Mit kezdjünk az újabb és újabb hangfelvételekkel?

2024. november 14. 16:53

Ezt a cikket 2024

novemberében írtuk.

A benne lévő

információk azóta elavulhattak.

Bármilyen AI-felismerő szoftvert is nézünk, száz százalékos választ még egyik sem tud adni arra, hogy egy hangfelvétel manipulált-e vagy sem. Adunk néhány támpontot, ami alapján érdemes tájékozódni.

Az elmúlt napokban a Magyar Péter és a Tisza Párt körüli nyilvánosság a különböző, titokban rögzített majd nyilvánosságra hozott hangfelvételekről szólt – ma délelőtt jelent meg az újabb adag. A hanganyagok hitelességét sorra kérdőjelezik meg politikai szereplők, médiumok, és folyamatosan megy a találgatás az egyszerű internetezők körében is.

Mivel várhatóan ez a téma következő napokban, hetekben is velünk marad, ebben a cikkben összegyűjtjük, milyen szempontokat érdemes figyelembe venni, ha a témában tájékozódunk.

Összefoglaljuk,

- hol áll eddig a sztori, ki mit állított a hangfelvételekkel kapcsolatban;

- milyen eszközök állnak rendelkezésre az mesterséges intelligencia által manipulált hangfelvételek felismerésére,

- és ezeknek az eredményét miért nem lehet száz százalékos ítéletként értékelni.

Mi történt eddig?

Magyar Péter politikai színrelépése óta nem most fordult elő először, hogy titokban rögzített hangfelvétek kerülnek elő: márciusban Magyar Péter hozott nyilvánosságra egy hangfelvételt, amelyen volt felesége, Varga Judit volt fideszes igazságügyi miniszter hallható. Ugyan a kormánysajtóban elterjedt, hogy a felvétel megvágott, a hanganyag valódiságát az érintettek akkor nem vonták kétségbe.

Az elmúlt napokban megjelent hanganyagokkal más a helyzet.

- Magyar Péter november 10-én, vasárnap arról beszélt egy sajtótájékoztatón, hogy hamarosan lejárató akció indul ellene, ami során „az illegális eszközökkel szerzett információkat, kép- és hangfelvételeket, valamint a Vogel Evelintől megvásárolt hangfelvételeket, valamint a mesterséges intelligenciával előállított hamisított felvételeket fogják keverni”. Magyar ekkor nyilvánosságra hozott egy kicsit több mint 3 perces felvételt, amelyen volt barátnője, Vogel Evelin Hanzel Erik vállalkozóval beszél, és amellyel Magyar azt szándékozott bizonyítani, hogy Vogel megzsarolta őt.

- November 11-én, hétfőn egy nem egészen másfél perces hangfelvételt küldött szét a sajtónak egy ismeretlen feladó, amelyen vélhetően Vogel és Magyar beszélgetése hallható, és többek közt az hangzik el, hogy „szétszedtek, negyven fokban mentünk át a Hősök terén, azt gondoltam, hogy mi a faszomat csinálok itt? Büdösek az emberek és a szájuk is.”

- November 12-én, kedden ugyanez az ismeretlen feladó elküldte a sajtónak a vasárnapi sajtótájékoztatón bemutatott, Vogel és Hanzel közti beszélgetés vágatlan, 1 óra 44 perces verzióját is.

A Vogel-Hanzel beszélgetés alapján a Magyar Nemzet, az Origo és az Index is arról cikkezett, hogy a vágatlan verzió bizonyítja, hogy a vasárnapi sajtótájékoztatón Magyar „hamisított” felvételt tett közzé – azaz a rövidített verzió manipulatív módon összevágott, kontextusából kiragadott mondatokat tartalmaz (az nem merült fel, hogy a felvételt AI segítségével manipulálták volna). Azt egyébként Magyar Péter sem titkolta, hogy a vasárnapi sajtótájékoztatón egy rövidített verziót játszottak le.

A másik, Vogel és Magyar beszélgetését tartalmazó felvételről pedig Magyar azt írta, hogy a hanganyag „egyértelműen összevágott és manipulált”. Emellett azt is állította, hogy a felvételen szereplő egyik mondatot biztosan nem ő mondta (azt nem jelölte meg, hogy melyiket).

Magyar reakciójában nem utalt arra, hogy ezt a konkrét felvételt (vagy egyes részeit) mesterséges intelligencia segítségével állították volna elő, azonban kommentben megosztotta az okoshír.hu cikkét, ami egy AI-felismerő szoftver, a Resemble Detect alapján állította, hogy

„a Vogel Evelin által rögzített hangfelvétel manipulált”.

Forrás: Facebook

Az okoshír.hu Facebook-oldalán november 11-én 14:38-kor hozták le a manipulációt állítólag bizonyító elemzést, Magyar Péter pedig nem egészen 20 perccel később, 14:56-kor említette meg kommentben az oldal cikkét.

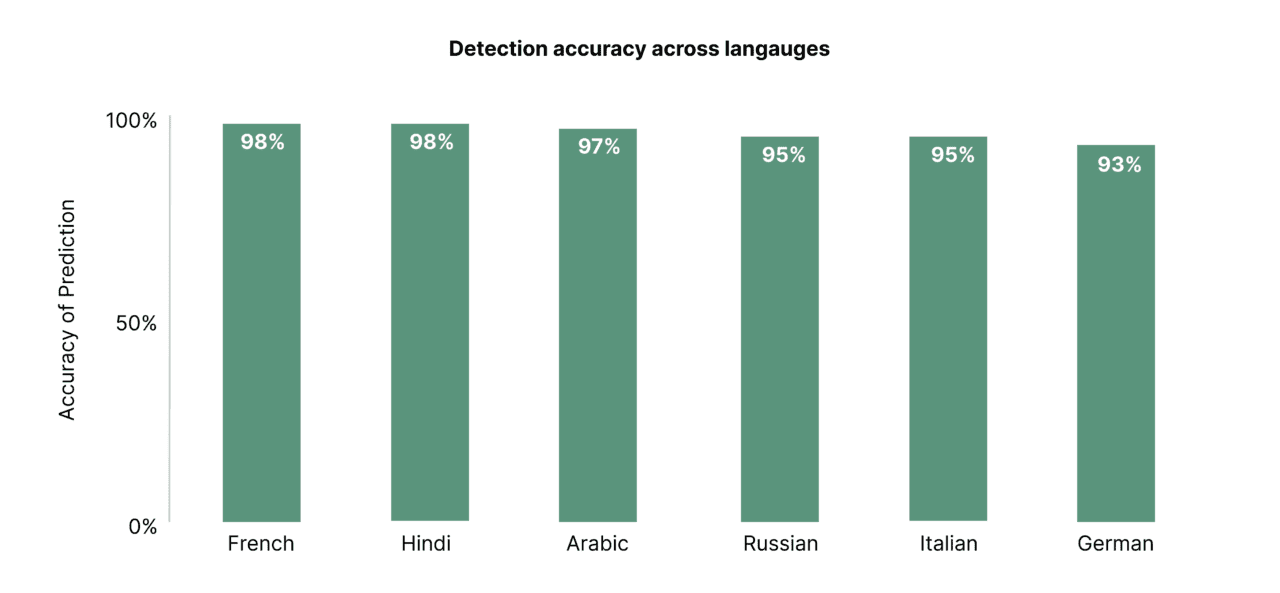

Mások is megvizsgáltatták a hangfelvételt az okoshír.hu által használt programmal. Egy Reddit-felhasználó 13:51-kor, a Vastagbőr blog pedig 18:13-kor posztolt arról, hogy a szoftver szerint „a ma kiadott MP-Vogel Evelin hangfelvétel nagy része fake”, a Vastagbőr alapján a Magyar Hang cikke is arról írt, hogy „úgy tűnik, belepiszkáltak” a felvételbe. A népszerűvé vált Tiktok-videójában pedig Pankotai Lili is erre az eszközre hivatkozva állította, hogy manipulált a hangfelvétel.

A Lakmuszon már korábban felhívtuk a figyelmet, hogy az ehhez hasonló kép-és hanganyagok eredetiségének, hitelességének a pontos megítélése nem könnyű feladat, sokszor a független sajtót is komoly kihívások elé állítja. Különösen amiatt, mert jelenleg

A Telex a mostani eset kapcsán tesztelt is néhány programot: az okoshír.hu és a Vastagbőr által használt AI-felismerő szoftver, a Resemble Detect a Vogel-Hanzel hangfelvétel nagy részét is hamisnak minősítette, más AI-detektálásra szakosodott hangelemző programok pedig nem mutattak ki manipulációt a Vogel és Magyar közötti beszélgetésen.

A Mynds.ai Telexnek nyilatkozó szakértője szerint ezek a szoftverek egyelőre nem igazán megbízhatóak, „nagyon rossz állapotban van a technológiának ez a része, ami a különböző deepfake vagy MI-generált tartalmak felismerését illeti”.

Nézzük, mit érdemes tudni ezekről az eszközökről!

1. Resemble Detect

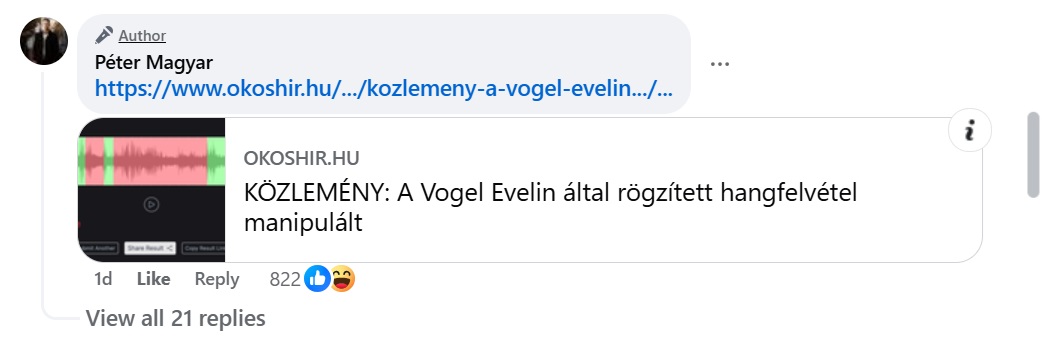

A Resemble Detect 2B a mesterséges intelligencia alapú hanggenerátor, a Resemble AI hangfelismerő modellje. Ez egy nagy méretű adathalmazon képzett, több almodellből álló rendszer, ami többféleképpen elemzi az audio deepfake-re utaló jeleket. Az almodellek segítségével elemzéskor külön „hamissági” pontszámot ad a hanganyag különböző részeire, majd egy küszöbértékkel összehasonlítva dönti el, hogy a hanganyag valódi vagy hamis. Az oldal azt állítja magáról, hogy több mint 94%-os pontossággal képes azonosítani a hamisítást.

Forrás: A Detect-2B eredményei a deepfake audio azonosításában, hat nyelven a deepfake audio előrejelzésében. Forrás: Resemble AI

A tesztelési folyamatuk leírásánál azonban csak 6 nyelv tesztelési eredményét tüntetik fel (a magyar nem szerepel ezek között), és nem derül kis az sem, hogy pontosan mennyi és milyen adatot használtak fel a teszteléshez. Az eredményekről nem állítják, hogy tévedhetetlenek lennének, azt írják hogy „A DETECT-2B képes helyesen azonosítani a deepfake hangklipek túlnyomó többségét, miközben nagyon alacsony hamis pozitív arányt tart fenn.”

Egy Reddit-felhasználó arra is felhívta a figyelmet, hogy a Resemble Detect a saját véletlenszerű tesztjén megbukott a magyar nyelvű szövegek azonosításában.

Forrás: Reddit

2. ElevenLabs és AI Speech Classifier

A Resemble Detect mellett a technológiai lapok az ElevenLabs-t tartják úttörőnek a deepfake hanganyagok készítésében, az oldal azonban a hanganyagok ellenőrzésére is alkalmas. A platform fő profilja alapján természetes hangzású beszédet képes előállítani mesterséges intelligencia (hangklónozás) segítségével.

Az eszköz 2023-ban arról híresült el, hogy a felhasználók hírességek szájába adtak olyan beszédeket, amelyek sohasem hangzottak el: hamis anyagokat készítettek Emma Watsonról, amint Adolf Hitler Mein Kampf című művét olvassa, Joe Bidenről, ahogy bejelenteti, hogy az amerikai csapatok bevonulnak Ukrajnába, valamint a Star Wars-színészekről, akik mélyen sértő, nőgyűlölő és rasszista üzeneteket mondanak.

Az eset után a ElevenLabs közölte, hogy biztosítékokat épít a szoftverbe a visszaélések megakadályozására, és létrehoznak egy olyan eszközt, amelyik be tudja azonosítani a mesterséges hangokat. Ez lett az AI Speech Classifier, ez azonban nem általánosan ellenőrzi a hanganyag manipuláltságát, csak azt állapítja meg, hogy a feltöltött hangfájl az ElevenLabs segítségével készült-e. Az oldal az ellenőrzés metódusáról nem közöl információt.

3. TrueMedia

A TrueMedia egy nonprofit, pártoktól független technológiai szervezet mesterségesintelligencia-alapú eszköze, ami deepfake videók, fényképek és hanganyagok észlelésére hozott létre Oren Etzioni, a Washingtoni Egyetem professzora. Célja a politikai dezinformáció elleni küzdelem volt a 2024-es választások előtt, ahogy a készítői fogalmaztak, hogy a mesterséges intelligenciát használjunk a mesterséges intelligencia elleni küzdelemben. Egy interjúban Etzioni úgy fogalmazott,

„egyetlen detektor sem tökéletes, mert a valószínűségek vezérlik őket”, majd hozzátette, hogy „még a legjobb eszközök használatával sem lehetünk biztosak”.

Az oldal a gyakori kérdéseknél az írja, hogy képes a hanganyagoknál érzékelni, hogy hangot manipulálták vagy klónozták-e, azonban a konkrét módszertant nem részletezi.

Magas hatékonyságot ígérnek, de független tesztek mást mutatnak

A tendencia hasonló a többi AI hangfelismerő eszköznél is: az AI or not szintén mesterséges intelligencia segítségével elemzi a hangfájlokat, azonban az elemzés módszertanát nem közlik, ahogyan az AI Voice Detector esetében sem, ami kutatás közlése nélkül arról tájékoztatja a felhasználókat, hogy „92%-os pontossággal képes azonosítani, hogy egy hang valódi vagy mesterséges intelligencia által generált”. A Pindrop szintén 99%-os sikert ígér, kevesebb mint egy százalék hamis pozitív eredménnyel.

Az egyre alacsonyabb költséggel egyre élethűbb gépi hangok fejlesztésében hatalmas a verseny – rendkívül széles a felhasználási terület a szórakoztatóipari médiatartalmaktól az egészségügyig. A másik oldalon szintén egyre nagyobb az igény a visszaélések csökkentésére az AI-alapú felismerő szoftverekkel. Egyes cégek ezért látják el egyedi audio vízjellel a generált tartalmat, más ellenőrző szoftverek más technológiákkal próbálkoznak – a jelek szerint egyelőre viszont nem támaszkodhatunk száz százalékban az eredményeikre.

Például az amerikai NPR közszolgálati rádió áprilisban három felismerő szoftver, a Pindrop Security, az AI or NOT, és az AI Voice Detector teljesítményét tesztelte – nem tudományos alapon – összesen 84 hangfelvétellelel. Ezeknek körülbelül fele származott az NPR valós rádióadásaiból, a másik felét pedig az AI-alapú PlayHT nevű hanggeneráló szofverrel készítették. Bár mindhárom eszköz 90 százalékos pontosságot ígér, a teszt alapján csak a céges felhasználású Pindrop teljesített 90 százalékos eredmény fölött. A lakossági felhasználású AI or Not az esetek felében, a Voice Detector csupán egynegyed arányban ismerte fel helyesen a felvételeket.

Deepfake és a politikai dezinformáció

Szakértők évek óta figyelmeztetnek a valószerű deepfake és AI-generált tartalmak veszélyeire, amelyek az identitáslopástól a különböző csalásokon (például családtagok hangját használó kamuhívásokon) keresztül a politikai célú dezinformációig terjednek. Újabban azt is hangsúlyozzák: az audio deepfake-ek, tehát a mesterséges intelligenciát használó generált, nem valódi hangfelvételek nagyobb kockázatot jelentenek jelenleg, mint a videós deepfake tartalmak.

Egyrészt azért, mert ezek előállítása egyszerűbb és olcsóbb, másrészt azért, mert alacsony költséggel lényegesen valószerűbb végeredmény állítható elő: míg egy glitch az arcon, vagy a furcsa ujjak néha még elárulják a vizuális AI-tartalmakat, addig ilyen árulkodó jeleket lényegesen nehezebb kiszúrni az AI-generálta hangfelvételeken. Erről a problémáról korábban Veszelszki Ágnessel a Lakmusz podcastjában beszélgettünk.

Különböző deepfake-ek tavaly kezdtek el politikai dezinformációs céllal feltűnni komolyabban világszerte. Az egyik legerősebb példa erre a 2023-as szlovákiai választás.

A Reset kutatása több olyan mesterséges intelligencia felhasználásával készült deepfake videót is beazonosított a közösségi médiában a választási kampány finisében, amelyekkel a Progresszív Szlovákiát (PS) igyekeztek besározni.

- Az egyik ilyen videón Michal Šimečka, a párt elnöke és egy újságíró beszélgetnek arról, hogyan fog a PS szavazatokat vásárolni szlovákiai romáktól.

- Egy másik deepfake felvételen, amit a szélsőjobboldali Republika párt osztott meg, Šimečka és Čaputová köztársasági elnök intik óva a szavazókat a „progresszív birkanyáj vakon követésétől”.

- Egy harmadik kísérletben pedig szintén Šimečka mesterségesen generált hangja szerepel: arról beszél, hogy pártja kormányra kerülése esetén az alkoholizmus visszaszorítása érdekében 70-100 százalékkal megemelné a sör árát.

A szlovák eset után az európai közvélemény jelentős része arra számított, hogy a a 2024. júniusi EP-választások előtt nagy számú deepfake tartalmakkal igyekeznek majd befolyásolni az eredményeket az ebben érdekelt szereplők. Azonban úgy tűnik, ez nem történt meg, a deepfake-özön elmaradt, továbbra is a hagyományos dezinformáció dominált. Ezt támasztja alá az is, hogy az európai tényellenőrzőket tömörítő European Fact-Checking Standards Network – aminek a Lakmusz is tagja – hálózatban az EP-választás előtt több mint 3000 médiatartalmat ellenőriztek az újságírók, és ebből 45 volt olyan, amit mesterséges intelligencia generált.

De ismerünk még példákat audio deepfake-ekre a közelmúltból Nigériából, Pakisztánból, Szudánból, az Egyesült Királyságból. A Financial Times összegzése szerint Indiában és Etiópiában később valódinak bizonyult hangfelvételeket hitetlenítettek azzal, hogy deepfake-nek bélyegezték őket.

Idén két amerikai eset is borzolta a kedélyeket. Az elmúlt hónapokban egy olyan audio deepfake keringett a közösségi médiában, amin Obama hangján mondja el a gép, hogy csak akkor lehetne biztosítani a demokrata győzelmet, ha megszabadulnának Trumptól, de ezt „az idióták elvétették”. A felvételt a NewsGuard elemezte, több AI-felismerő szoftver és digitális szakértő bevonásával, így jutottak arra, hogy a hangfelvétel hamis.

Még az előválasztások idején, 2024 januárjában New Hampshire-ben több ezer potenciális demokrata szavazót hívott fel egy Joe Biden hangján beszélő gép, és a választókat távolmaradásra biztatta. Sajtóinformációk szerint Biden mesterséges hangját az ElevenLabs szoftverrel készítethették, amelyről már a cikk elején is írtunk. Az ElevenLabs egyébként a terület egyik legsikeresebb cége –akkor izzottak fel a viták körülötte, amikor lehetővé tette, hogy a gép hírességek hangján mondjon el bármilyen, a felhasználó által begépelt szöveget. Ezt a szolgáltatását később a cég fizető felhasználókra korlátozta. Az eset után betiltották az AI-hangot használó politikai gépi telefonhívásokat az Egyesült Államokban.

Fontos azonban megjegyezni, hogy a politikai dezinformáció terjesztésében a deepfake csak egy újabb eszköz – a hamis információk legnagyobb része bármiféle technikai segítség nélkül, vagy jóval egyszerűbb, úgynevezett „cheap-fake” hamisítványokon keresztül terjed napjainkban. A deepfake terjedése azonban azt a nagyon is valós veszélyt hordozza magában, hogy bárminek a valódiságát meg lehet kérdőjelezni, és mivel száz százalékos bizonyosságot adó ellenőrzési lehetőségek még nincsenek, még inkább hit- vagy meggyőződés alapján döntik el az emberek, mit tartanak valósnak. Erről a problémáról nemrég az Európa Pontban egy deepfake-kel foglalkozó rendezvényen beszélgetett Mezriczky Marcell deepfake kutató, Krekó Péter, a Political Capital igazgatója és Zöldi Blanka, a Lakmusz főszerkesztője.

De akkor hogyan védekezzünk ellene?

Ha az audio deepfake-eket ilyen nehéz nagy biztonsággal kiszűrni, akkor mit tehet a nyilvánosság, hogyan védekezhetünk ellenük? A következőkben a Deutsche Welle és a Global Investigative Journalism Network témában született tanácsait foglaltuk össze:

- Ne támaszkodjunk sem a megérzésünkre, sem egyetlen deepfake-felismerő szoftver eredményére, ehelyett többlépcsős ellenőrzést végezzünk és több szoftvert használjunk.

- A felismerő szoftverek eredményére úgy tekintsünk, mint valószínűségre, ne úgy, mint közvetlen bizonyítékra. Erről a korlátról az újságírók tájékoztassák az olvasóikat, amikor használják őket.

- A hamis tartalmakat sokszor úgy állítják elő, hogy érzelmekre hassanak, erre különösen alkalmasak az audio deepfake-ek. Ezért általános tanács, hogy álljunk meg, gondolkodjunk és gyanakodjunk.

- Hasonlítsuk össze a gyanús felvételen elhangzó beszédet a hiteles felvétellel ugyanarról az emberről: a hasonló szavak kiejtésében hallgató különbség, a természetellenes szünetek, nem reális levegővétel-ritmus mutathatja az AI nyomait. Egyetlen rövid kis hang szokatlan, idegen kiejtése az anyanyelvi beszélőknél elárulhatja az AI-t.

- Használjuk a hagyományos ellenőrző technikákat, vizsgáljuk meg a tartalmat és a kontextust: milyen viszonyban van a felvétel tartalma a már megerősített tényekkel, mi a felvétel forrása, mi tudható róla a közösségi média felületeken vagy a domainadatokból?

- Vizsgáljuk meg a felvétel terjedését az interneten és a közösségi médiában.

Címlapi kép: Barczikai Fanni

A szerzőkről

Pálos Máté

Az ELTE BTK-n végzett, szerkesztett folyóiratot, írt kritikákat. 2014 óta teljes állásban újságíró. Dolgozott a régi Origónál, a Magyar Narancs hetilapnál és a G7.hu gazdasági portálnál. 2024-ben csatlakozott a Lakmuszhoz, 2025 márciusa óta szerkeszt is.

Fülöp Zsófia

2023 májusától a Lakmusz újságírója, korábban 9 évig a Magyar Narancsnál dolgozott, főként egészségügyről, szociális ügyekről és marginalizált csoportokról írt. Az oxfordi Reuters Institute ösztöndíjasaként a romák médiareprezentációját kutatta.

Barczikai Fanni

A Budapesti Corvinus Egyetemen végzett politológus, az ELTE-BTK mesterszakos hallgatója. Az Achilles Data nemzetközi oknyomozó újságíró program díjazottja és a Pelikán Projekt okleveles újságírója. A Lakmusz csapatához 2024 márciusában csatlakozott.

Kövess minket!

Ne maradj le egy anyagunkról sem, kövess minket máshol is!

Ajánlott cikkeink

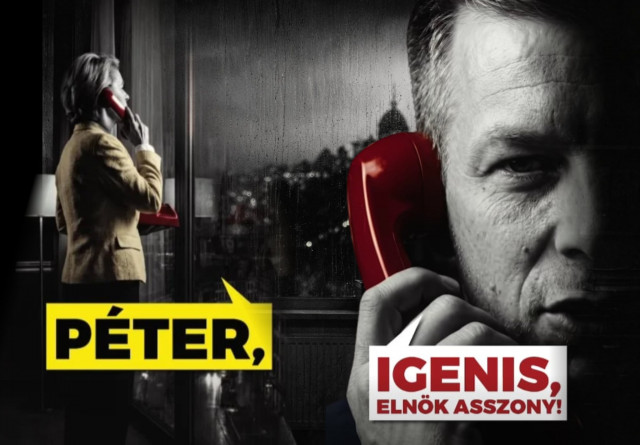

Fizetett hirdetésekben is futtatják az AI-videót, amiben Ursula von der Leyen piros telefonon hívja fel Magyar Pétert

Ötödik emeletig érő hó? A valódiak mellett AI-generált képek is terjednek az extrém kamcsatkai hóhelyzetről